LSTM是Long Short-Term Memory的缩写,是一种特殊的RNN结构。相比于标准RNN,LSTM在结构上具有以下改进:

1. LSTM使用遗忘门来控制上一时刻状态的遗忘程度,可以有效缓解长时依赖的学习问题。

2. LSTM使用输入门来控制当前输入的重要程度。输入门可以判断当前输入对输出预测的重要性,选择性地遗忘或更新状态。

3. LSTM使用输出门来控制将要输出的状态信息量。输出门可以根据需要只输出状态中的一部分信息。

4. LSTM通过使用状态以外的“细胞”来传递长时依赖的信息,状态只更新和输出那些对学习任务重要的信息。

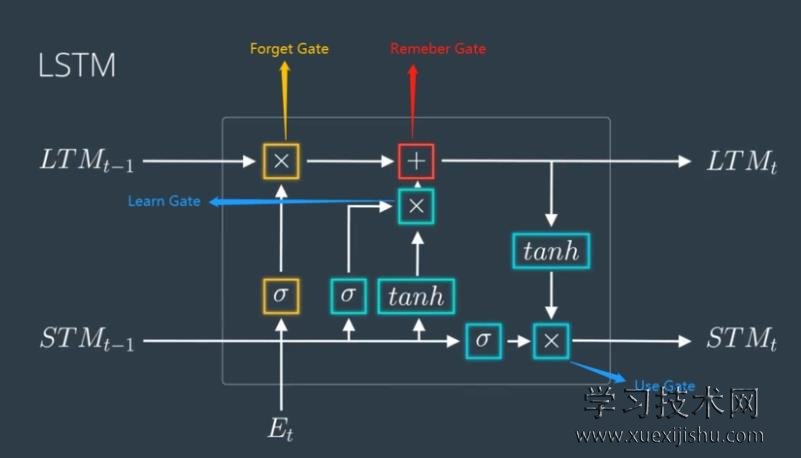

具体地,一个LSTM单元主要由以下结构组成:

- 遗忘门:使用sigmoid函数将上一状态的信息遗忘到一定程度。

- 输入门:使用sigmoid函数来判断当前输入的重要性。

- 状态更新:将遗忘后的上一状态与当前输入 gate 后的值更新到状态上。

- 输出门:使用sigmoid函数判断当前状态值的重要性并输出。

- 状态:传递长时依赖信息的“细胞”,只更新对学习任务重要的值。

该结构使LSTM在学习长时依赖的任务上表现优异,它已被广泛应用于语言建模、机器翻译、语音识别与图像描述生成等需要建立长时依赖的任务中。

相比于RNN,LSTM三种门机制与细胞状态使其在学习长序列的过程中能够有选择地遗忘或更新信息,这大大缓解了梯度消失与梯度爆炸的问题。但LSTM仍需大量数据与强大计算资源用于在具体任务上进行优化,要达到人类级的语言理解与生成还需要更加强大的神经网络结构。

希望以上内容可以帮助你进一步理解LSTM。深入学习与研究循环神经网络将有助于你在NLP与其他序列学习任务取得更大成就。LSTM带来了循环结构的重要改进,但要实现具备推理与联想能力的语言系统,我们仍需不断探索。让我们在这条道路上共同努力。